环境信息

- EMQX 版本:4.4.1

- 操作系统及版本:centos7.5

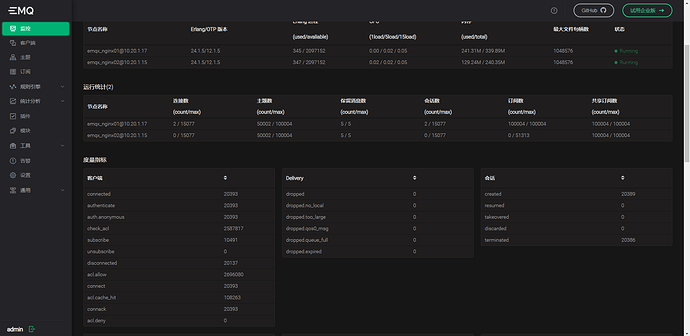

- EMQ实例: 4C8G * 2

问题描述

场景如下:

- Topic: 5W

- 共享订阅数: 10W

- Pub:5

- Sub: 2

- MQTT 连接:1W

- 初始方并发数:100

- 每 5 分钟提高并发数:50

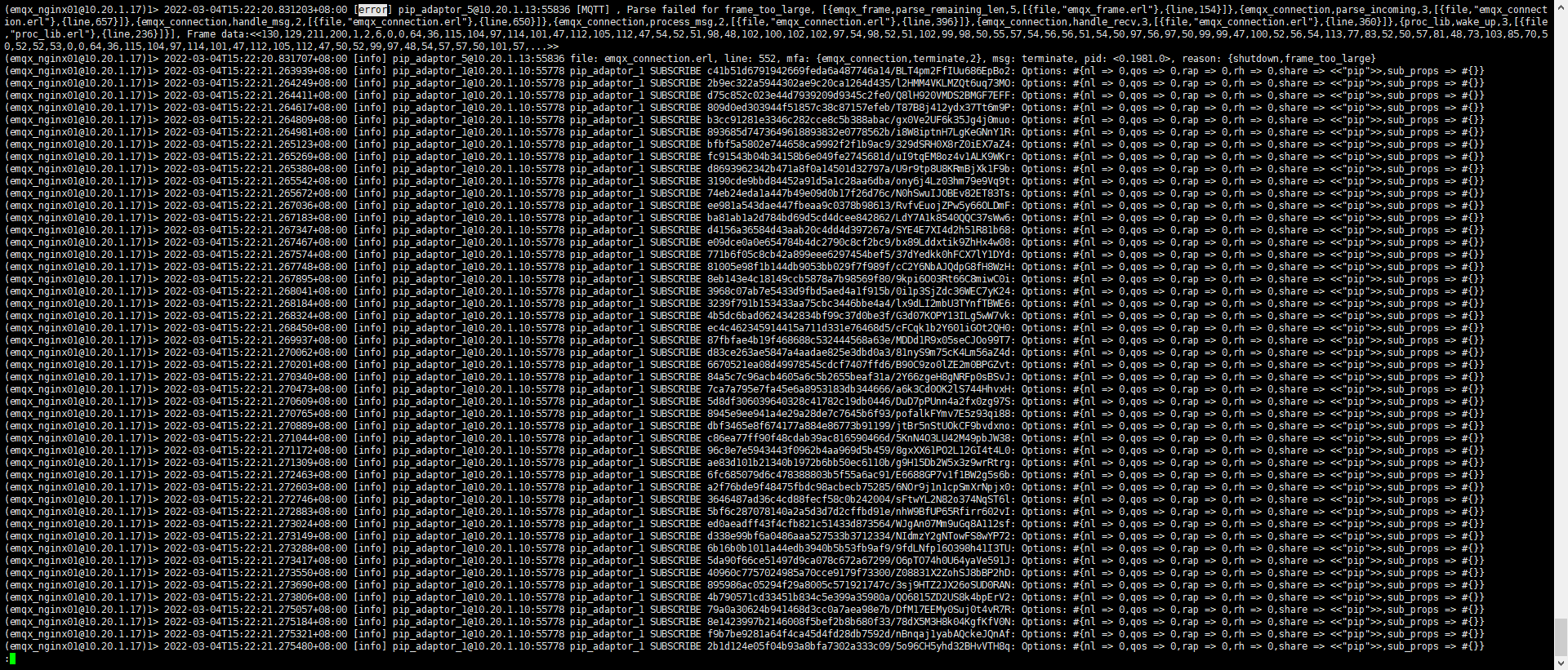

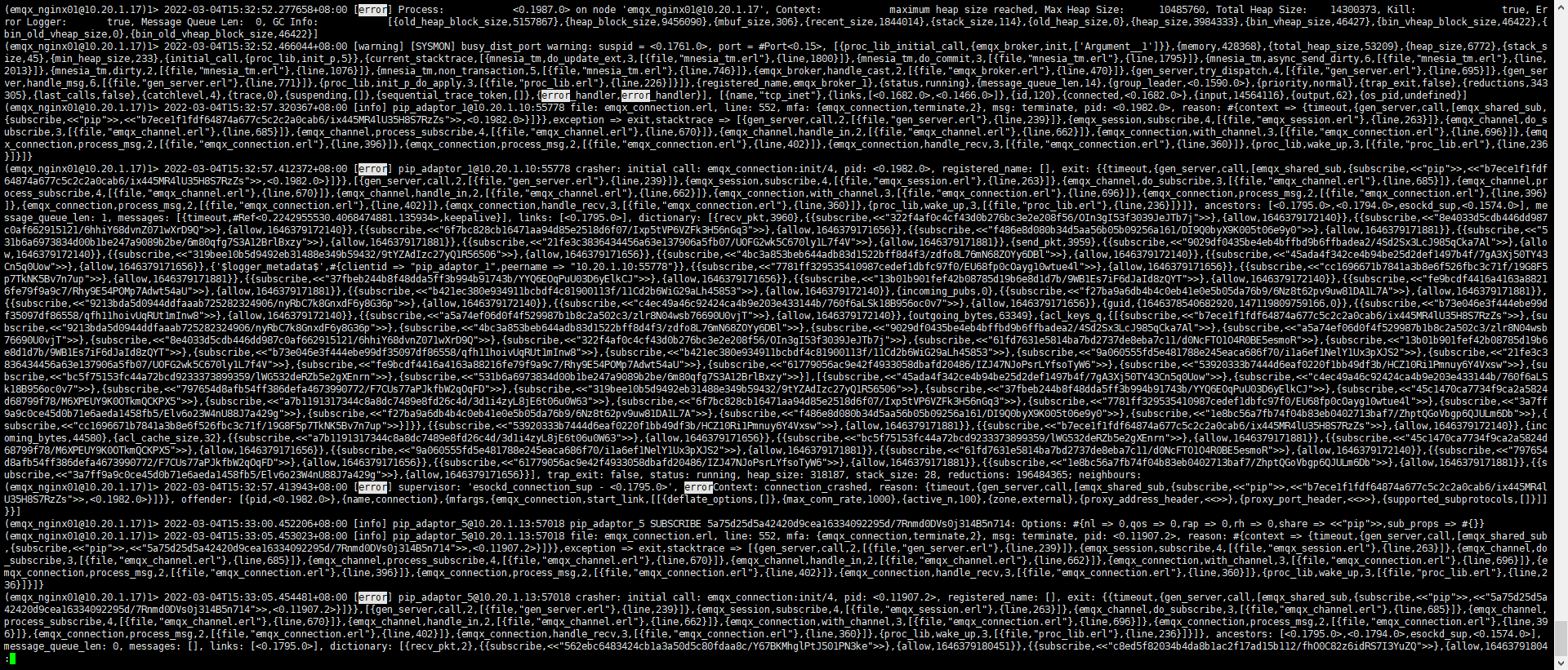

当开始尝试测试时出现发送数据失败,消费端连接断开

压测开始时 CPU 使用率飙升到 80% , load average: 4.2

emq dashboard 告警: System memory usage is higher than 70.0%

CPU 信息如下

EMQ 2台 4C8G 服务器配置的情况,该测试场景失败。是服务器资源不够,还是我配置的原因?配置参考了 https://www.emqx.io/docs/zh/v4.4/tutorial/tune.html#linux-操作系统参数

配置文件及日志

错误日志: