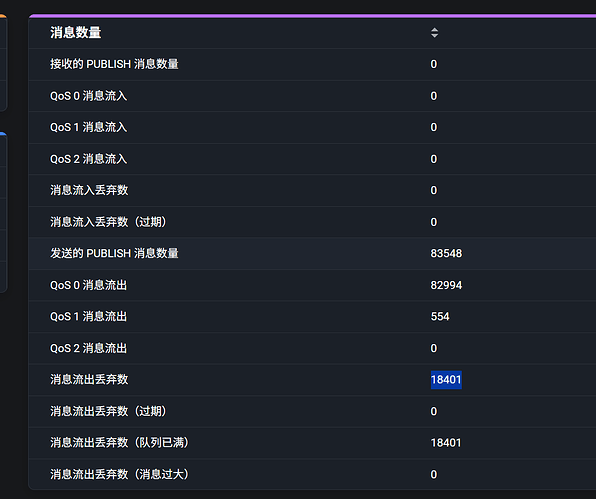

2025-12-29T17:03:15.848867+08:00 [warning] msg: dropped_msg_due_to_mqueue_is_full, mfa: emqx_session:handle_dropped/3, line: 644, peername: 172.10.1.7:36969, clientid: mqtt2kafka-client-4410945490694820, topic: dev/monitor/301323120124, payload: #{extra => ,flags => #{dup => false,retain => false},from => <<“301323120124-0ed5d6e6”>>,headers => #{peerhost => {172,10,1,7},properties => #{},proto_ver => 4,protocol => mqtt,redispatch_to => {<<“mqtt2kafka”>>,<<“dev/monitor/#”>>},username => <<“xxxxxx”>>},id => <<0,6,71,19,119,140,35,71,67,98,113,0,26,27,18,35>>,qos => 1,timestamp => 1766998795887,topic => <<“dev/monitor/301323120124”>>}, queue: #{dropped => 1502,len => 1000,max_len => 1000,store_qos0 => true}

2025-12-29T17:03:24.288969+08:00 [SOCKET] mqtt2kafka-client-liuwei-4410945490694820@172.10.1.7:36969 msg: socket_force_closed, reason: keepalive_timeout

2025-12-29T17:03:24.302751+08:00 [SOCKET] mqtt2kafka-client-liuwei-4410945490694820@172.10.1.7:36969 msg: emqx_connection_terminated, reason: {shutdown,keepalive_timeout}